Se ha hecho viral un video de un joven que muestra como a través de WhatsApp su mamá le envía una serie de audios, pidiéndole dinero. Sin embargo, detrás de toda esta situación está la inteligencia artificial, copiando la voz de ella para hacerle creer a su hijo que está en una situación en la que necesita el dinero pronto, algo que también es posible al robo de cuentas en la aplicación.

Esta modalidad de ataque se conoce como visihing, en la que se usa la IA para clonar la voz de una persona para suplantar su identidad y enviar un mensaje falso para solicitar dinero o datos personales, todo justificado mediante una petición cercana a la víctima.

Únete a nuestro canal de WhatsApp y recibe al instante las últimas noticias de San Luis Potosí y del mundo. 👉 Haz clic aquí para unirte: https://whatsapp.com/channel/0029VankAjrEgGfFSMCatY1i

Cómo es la estafa viral de clonación de voz en WhatsApp

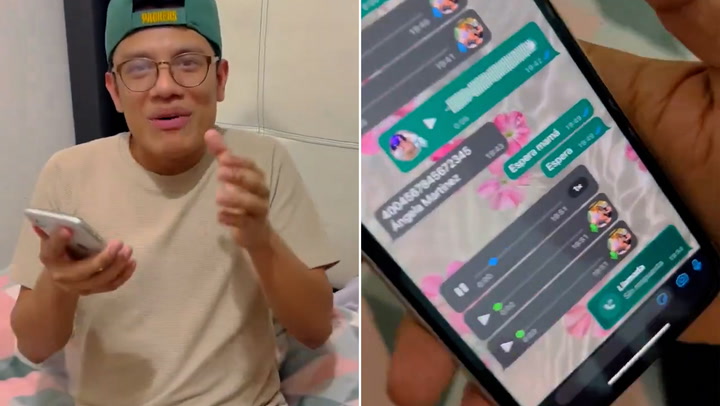

En el video publicado, un joven muestra el chat que tiene con su mamá en la aplicación de Meta, allí aparecen una serie de audios en los que ella le está pidiendo con urgencia que le envíe dinero a una cuenta.

Ante esta situación, él le responde a su supuesta mamá que ya mismo le hace la transferencia a la cuenta de siempre. Sin embargo, desde los audios le insisten que no lo haga porque no tiene la tarjeta para retirar el dinero de esa cuenta habitual y le envían los datos de transferencia para otra persona, que supuestamente es una amiga de ella.

Toda esta situación es grabada con la mamá al lado y en los audios se evidencian errores en la dicción, que normalmente son generados al clonar una voz con inteligencia artificial, lo que le permitió identificar a la víctima la falsedad del ataque.

Si bien lo que sucede puede parecer fácil de captar y no caer en la trampa, este tipo de amenazas cada vez están más pulidas y si los usuarios revelan datos personales, será mucho más sencillo para los ciberatacantes personalizar los audios para aumentar la percepción de realidad de la situación.

Cómo funciona la clonación de voz con inteligencia artificial

La clonación de voz utiliza algoritmos de inteligencia artificial y redes neuronales para crear un modelo sintético de la voz de una persona. Según expertos en ciberseguridad, el proceso solo necesita algunos segundos de grabación, en ocasiones tan solo tres, para generar una réplica que imita el tono, el timbre y las inflexiones del habla.

En el caso del vishing (la suplantación de identidad mediante voz) los estafadores capturan el audio de la víctima a través de redes sociales, videos públicos o incluso realizando una llamada falsa para grabar la voz. Una vez que se tiene una muestra de audio, los estafadores utilizan esta tecnología para generar palabras o frases que la persona original nunca pronunció.

Para complementar esta estafa, los ciberdelincuentes roban cuentas de WhatsApp y contactar a las víctimas. Para llevar a cabo este robo, los estafadores obtienen el número de teléfono de la víctima y, luego, intentan registrar la cuenta en otro dispositivo. Esto genera un código de verificación que WhatsApp envía vía SMS al número de la víctima como medida de seguridad.

Aquí es donde los delincuentes suelen engañar a la persona, enviándole un mensaje urgente que la persuade de compartir el código de seis dígitos. Si la víctima cae en la trampa, el estafador toma control de la cuenta de WhatsApp.

Con la cuenta robada y el acceso a los contactos, el estafador envía mensajes de texto y audios clonados a familiares y amigos de la víctima, solicitando dinero urgente a través de métodos digitales. La familiaridad de la voz y el acceso a la cuenta de WhatsApp de un ser querido hace que la solicitud de ayuda parezca auténtica, logrando que muchas personas caigan en la estafa.

Cómo protegerse de la clonación de voz y el robo de cuentas

- Limitar el uso de grabaciones de voz en redes sociales y plataformas públicas. Cuanto menos contenido de voz haya disponible, más difícil será para los delincuentes clonar la voz.

- Configurar palabras claves familiares que permitan confirmar la identidad en situaciones de emergencia. Preguntas sencillas, como “¿cuál es el plato preferido de la abuela?”, pueden ayudar a verificar si realmente se está hablando con la persona adecuada.

- Evitar compartir códigos de verificación de WhatsApp. Si recibes un mensaje solicitando el código, es casi seguro que se trata de una estafa. WhatsApp no solicita estos datos por mensaje.

- Mantener los dispositivos actualizados y seguros. Actualizar el software y utilizar contraseñas fuertes disminuye las probabilidades de sufrir un ataque cibernético. La autenticación multifactor también es una medida eficaz para proteger las cuentas en línea.

Con información de: Infobae